אז על מה נדבר?

- מהי סריקה / זחילה?

- מהן בעיות הזחילה הנפוצות

- איך נתייג את העמוד באופן נכון לסריקה ולהוסיף אותו לאינדקס של גוגל

- אפשרויות לשיפור זחילה

מה זו הזחילה/סריקה של מנוע החיפוש?

זו היכולת של מנוע חיפוש, כמו גוגל, לחפש ולמצוא תוכן באתר. אם הבוטים של מנוע החיפוש נתקלים בבעיות לשלוח את הזחלנים לסרוק את האתר למשל כמו: חוסר בקובץ robots.txt , קישורים שבורים, שגיאות שרת ועוד .. הוא פשוט לא סורק את התוכן בעמוד ומאנדקס אותו – כך שהוא לא יופיע בתוצאות החיפוש אצל הגולשים.

תיקון שגיאות אלו הוא חשוב ביותר נמצא תחת הכובה של SEO טכני . אם השגיאות לא יתוקנו, לא משנה כמה קישורים או מאמצי שיפור תוכן תבצעו העמוד ימשיך לא להסרק ולהופיע בתוצאות החיפוש.

בעיות סריקה נפוצות

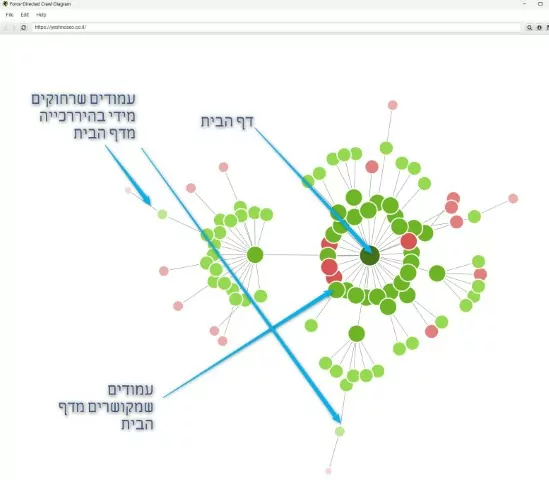

מבנה האתר ופרופיל הקישורים הפנימיים

בפשטות – כמה רחוק התוכן נמצא מעמוד הבית, איזה מסע הגולש צריך לעבור כדי להגיע אל התוכן שלך מהעמוד הראשי. האם התוכן נמצא איפה שהוא בעמוד שהוא מספר 4 5 6 בהיררכיה של העמודים מהעמוד הראשי או בדף 2 3?

מבנה האתר הוא הצורה שבה הדפים באתר מקשרים אחד עם השני – או שבאמצעות היררכיה או באמצעות קישורים פנימיים.

אם מבנה האתר שלכם מסורבל הזחלנים של מנועי החיפוש ייתקלו בקושי לגלות עמודים שנמצאים בתחתית ההיררכיה או שאינם מקושרים מעמודים אחרים (העמודים הללו נקראים "דפים יתומים" – “orphaned pages”).

לדוגמא:

היררכייה נכונה לאתר היא כך:

קודם כל דף הבית. מתחתיו הקטגוריות הראשיות , לאחר מכן, אם יש (לא חובה), תת קטגוריות ולמטה המוצרים והמאמרים.

לפי מה שאני יודעת, גוגל סורקת את האתר מלמעלה (דף הבית) למטה.

לכן, כפי שאמרתי בהתחלה, אם העמודים נמוכים מידי ורחוקים מעמוד הבית , ושאין קישורים שמפנים אליהם מעמודים ראשיים יותר, כך ל googlbot החמוד יהיה קושי למצוא אותם.

באמצעות כלי כמו screamin frog תוכלו לראות את מבנה האתר שלכם ולמצוא את אותם עמודים שנמצאים במרחק של מעל 3 קליקים מעמוד הבית.

שגיאות שרת

שגיאות שרת, כמו שגיאות 502, מונעות מהזחלנים של גוגל ומנועי החיפוש האחרים, לזחול בעמודי האתר. באמצעות Google Search Console תוכלו לדעת אם קיימות שגיאות שרת 5xx, מה שאומר ש-Googlebot לא הצליח לגשת לדף, תם הזמן הקצוב לטעינה או שהאתר היה עמוס מדי.

שרת עמוס ככל הנראה יפסיק להגיב לבקשות של גולשים וזחלנים כאחד, להיכנס לאתר, כלומר, הדף לא ייסרק ולא תהיה בו תנועה.

אם יש לכם הרבה שגיאות מהסוג הזה, הפתרון לרוב יהיה להגדיל את נפח האחסון או להחליף לשרת טוב כמו קלאודוויז – שם אין לי את הבעיות הללו ואליו העברתי את מרבית האתרים שלי – נסו

קישורים שהם לא בקוד HTML

אם הקישורים באתר אינם טקסט פשוט כמו, JavaScript, יש מצב שגוגל לא סורקת אותם וכך גם לא מגיעה עם הקישור לעמוד שאליו הם מובילים , כך שייתכן שגם הוא לא נסרק.

מה שצריך לעשות זה להשוות גרסת טקסט של האתר עם הגרסה שמוצגת

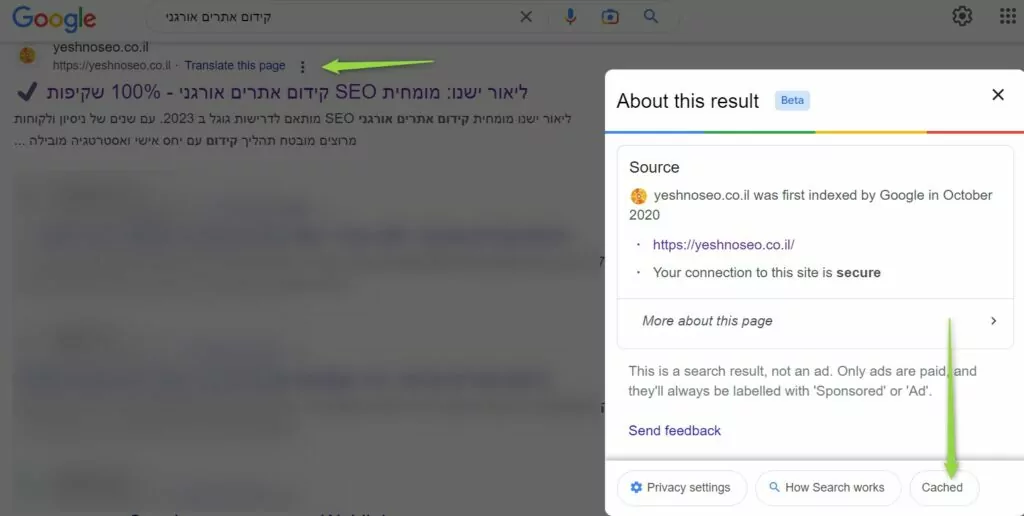

- תמצאו את העמוד ממנו יוצאים קישורים לעמוד שלא נסרק- בעמוד תוצאות החיפוש.

ואז תלחצו על שלושת הנקודות ליד התוצאה (או החץ הקטן, תלוי עם איזה דפדפן וגרסא אתם עובדים). - לאחר מכן בחלונית שתפתח לחצו על “Cached”. "במטמון".

- כשייפתח העמוד לחצו על גרסת הטקסט.

מעולה!

עכשיו תראו אם הקישורים מופיעים או לא (תוכן עם קו למטה שמסמל קישור). אם לא כנראה שגוגל לא סורקת אותם.

בקיצור, הקפידו על קישורים מבוססי טקסט או תמונה. תשתדלו להימנע מכל מיני אלמנטים מורכבים כמו JavaScript שמפריעים לזחלנים של מנועי החיפוש.

הפניות 301 Redirects

תמיד נראה שהפתרון של מקדמי אתרים למיניהם זה – "מה הבעיה, נעיף את העמוד ונעשה הפניית 301" – בחלק מהמקרים זה הכי נכון שיש, אני לא אומרת שלא. אבל כן, זה לא כזה " מה הבעיה" נכון שטכנית זה דיי קל לביצוע אבל צריך לבדוק גם משמעויות נוספות שיש מעבר לביצוע הטכני עצמו.

כמו למשל:

איזה עמודים קישרו אל העמוד שמקבל הפניה, ולאן העמוד הזה קישר לפני שקיבל הפניה. צריך לוודא את הדברים הללו כדי לא ליצור לולאה של הפניה >> להפניה >> להפניה…. ואז אם אתם הולכים לאיבוד, גם הזחלנים של גוגל יילכו, ולא יסרקו אף אחד מהדפים בלולאה הזאת.

צריך לתקן את הקישורים הללו לפני שמבצעים הפניה בפועל כדי לא לייצר שגיאות.

יש גם את העניין של הפניות לדפים שמנותבים מחדש כמו HTTP ל HTTPS עם / בלי / בסוף הURL וכו'…

בקיצור ודאו שאין לכם עודף הפניות באתר . אפשר להשתמש בכלים כמו HTTP Status Checker כדי לבדוק אם יש בעיות בהפניות.

חסימת גישה בקובץ robots.txt

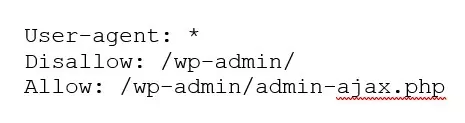

קובץ robots.txt זהו הקובץ הראשון שהזחלנים של מנועי החיפוש נתקלים בו. באמצעותו אפשר לחסום בכוונה תחילה זחלנים של מנועי חיפוש מלזחול באתר ולסרוק אותו או עמודים מסוימים.

נהוג לחסום עמודים שהם למשל עמודים של מנויים שמכילים מידע רגיש על הגולש, עמודי תשלום שמכילים פרטי כרטיס אשראי ועוד דוגמאות שבאמת לא נרצה שגוגל יסרוק ויאנדקס את העמודים הספציפיים הללו.

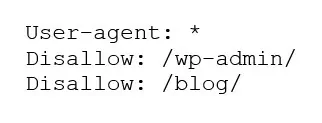

אבל, אם נחסום את עמודי הבלוג? או עמודי המוצרים? או עמוד הבית (רחמנא ליצלן), בטעות , או כי בנינו אתר והמפתח שכח להסיר את החסימה כשסיים לעבוד עליו – מן הסתם אנחנו אומרים לגוגל . לא , אל תסרוק ותאנדקס את האתר ופספסנו את הפואנטה כי גולשים ולקוחות פוטנציאליים לא ייחשפו לתוכן ולמוצרים המצוינים שיש לנו להציע להם.

כנסו לקובץ רובוטס שלכם ובדקו שאין שם בעיות:

פשוט כתבו בשורת הURL בדפדפן שלכם:

Https://your-domain/robots.txt

דוגמא לקובץ תקין: ✅

דוגמא לקובץ לא תקין שחוסם את כל עמודי הבלוג ❌

מפת אתר – הגשת כבר?

XML Sitemap זהו מושג שחוזרים עליו הרבה בעולם קידום אתרים, אבל בינינו – לא על זה יקום ויפול דבר.

בגדול מפת האתר חיונית כדי לומר לגוגל איזה דפים אתה מגדיר כחשובים, לדעתך, באתר שלך. ובכך אנחנו מכוונים את גוגל לסרוק את העמודים שאנחנו רוצים שייסרקו.

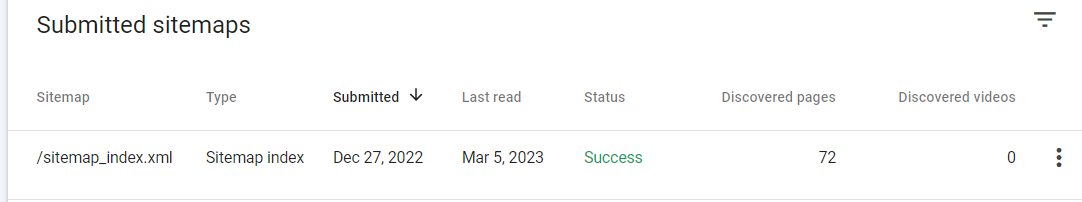

ודאו שאין שגיאות במפת האתר שלכם, שכל העמודים הרלוונטיים כלולים בה ועמודים שאינם רלוונטיים לא נכללים במפה, ותגישו לגוגל.

כמו כן, ממליצה להוסיף מפת אתר בHTML (שזה עמוד עם כל הכתובות וההיררכיה של האתר שמקשרים לעמודים שכלולים בה) לאתר שלכם – שימו קישור בפוטר לעמוד מפת האתר (מוזמנים לגלול מטה לפוטר שלי לראות דוגמא).

תקציב זחילה

גוגל סורקת ומאנדקסת כמות מסויימת של דפים (המוווון כן) במסגרת זמן מסוימת. אם יש לך המון דפים וחרגת מתקציב הזחילה כנראה שחלק מהעמודים לא יתווספו לאינדקס.

תכלס, רוב האתרים לא צריכים לדאוג לגבי זה. מה שכן חשוב עבור רובכם – שימו לב לא להעלות הרבה עמודים במכה כי לא כולם יתאנקדסו מהר.

טפטפו אותם בקצב הגיוני. (למשל לא להעלות באתר של 5 עמודים, ביום בהיר אחד 1000 מאמרים חדשים כי הייתם בשוונג כתיבה)

כמו כן, אם יש לכם הרבה הפניות לאתרים חיצוניים זכרו שהם יכולים לבזבז מתקציב הזחילה שלכם, אני לא אומרת שזה לא נכון "SEOאיט" לשלב קישורים חיצוניים באתר שלך – זה דווקא מאוד נכון. כמו בכל דבר בחיים, יש אמצע.

תקשרו ברמת הסביר ובאופן הגיוני לאיפה שצריך ומתי שצריך .

נסרק או לא נסרק, זו השאלה?

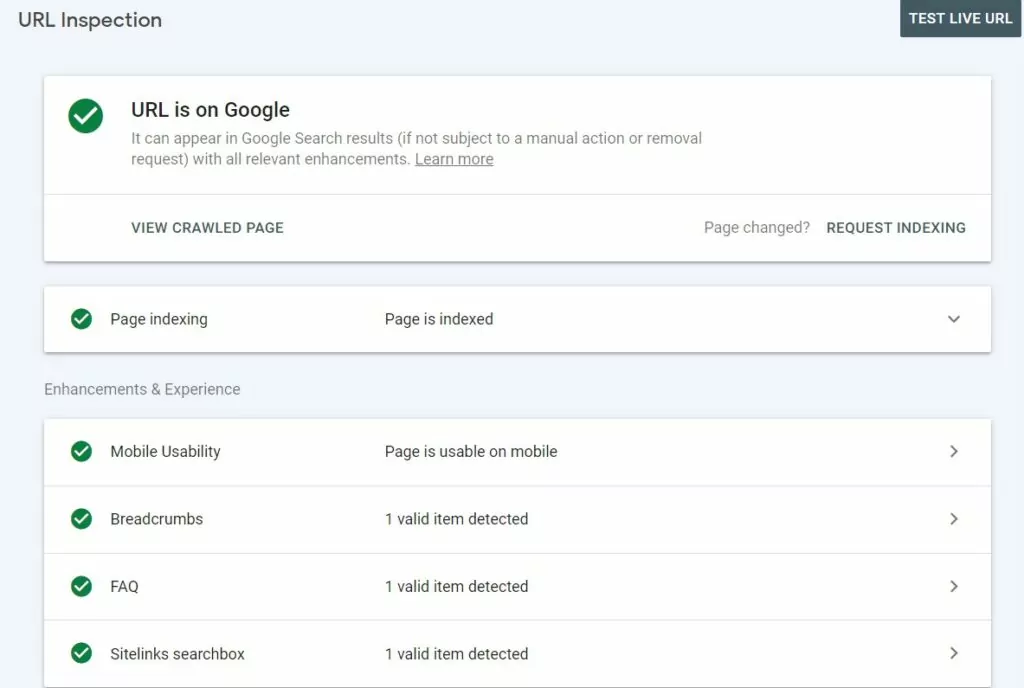

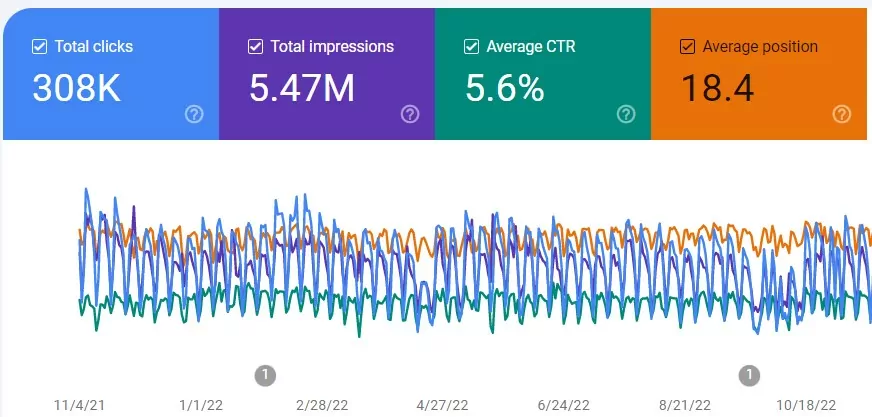

איך לבדוק אם העמוד נסרק בגוגל? מאוד פשוט – באמצעות גוגל סרץ' קונסול.

פשוט תזינו את הכתובת בinspect למעלה ולחצו ENTER

אם הכל נסרק ואין בעיות תראו את העמוד צבוע בירוק עם V נחמד.

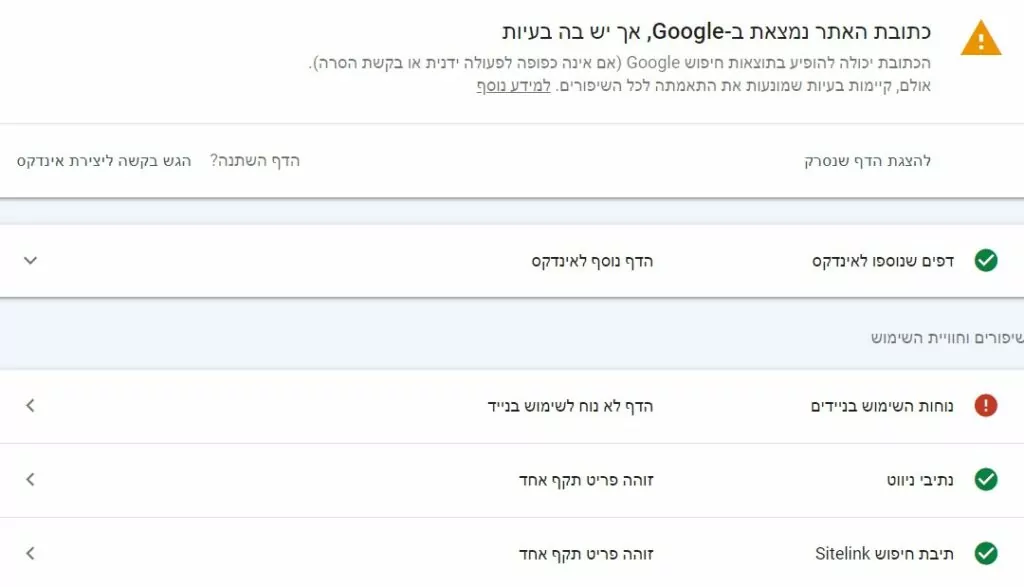

אם יש שגיאות – תראו סימנים אדומים (שאנחנו לא אוהבים ורוצים לתקן אותם)

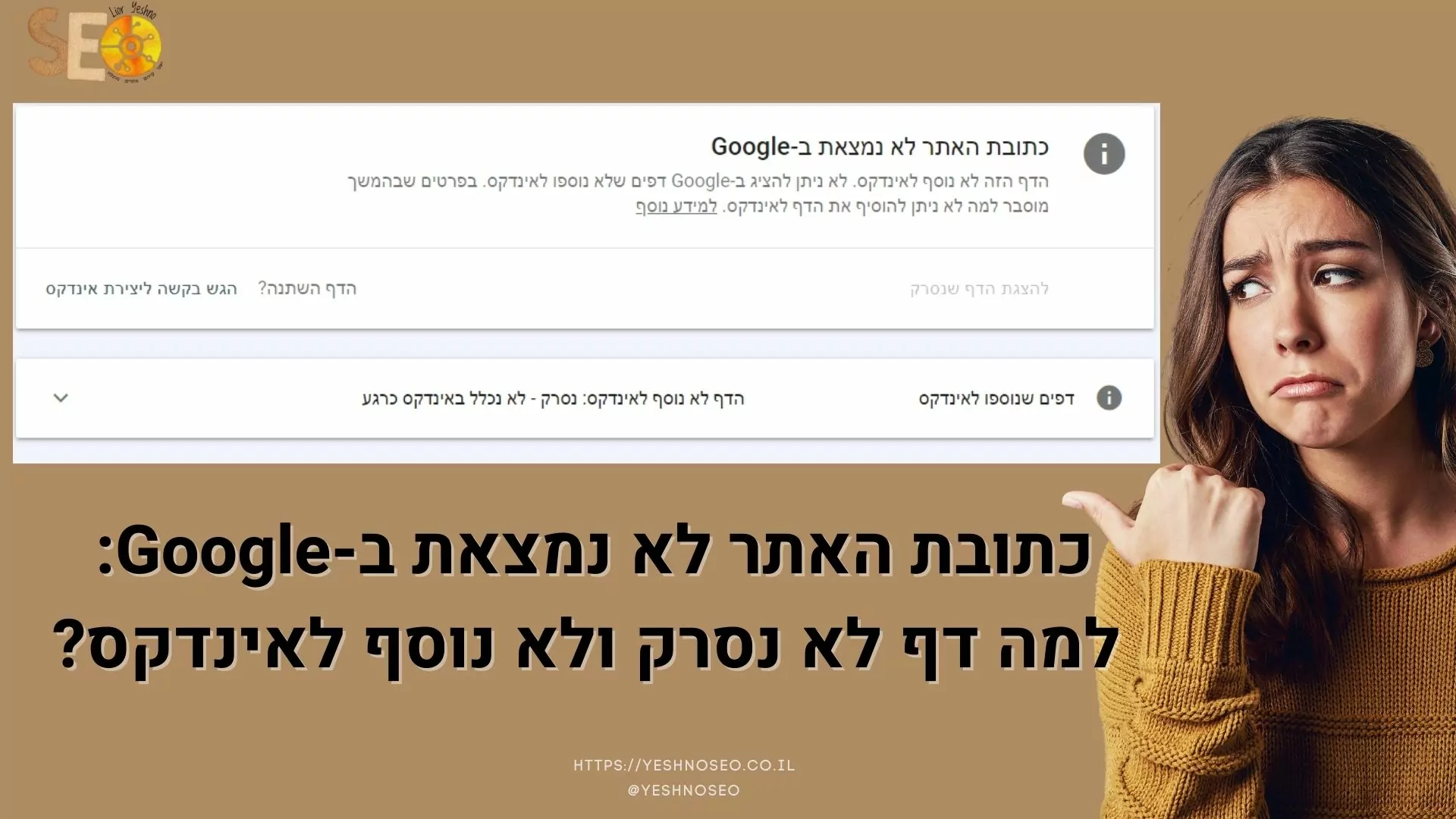

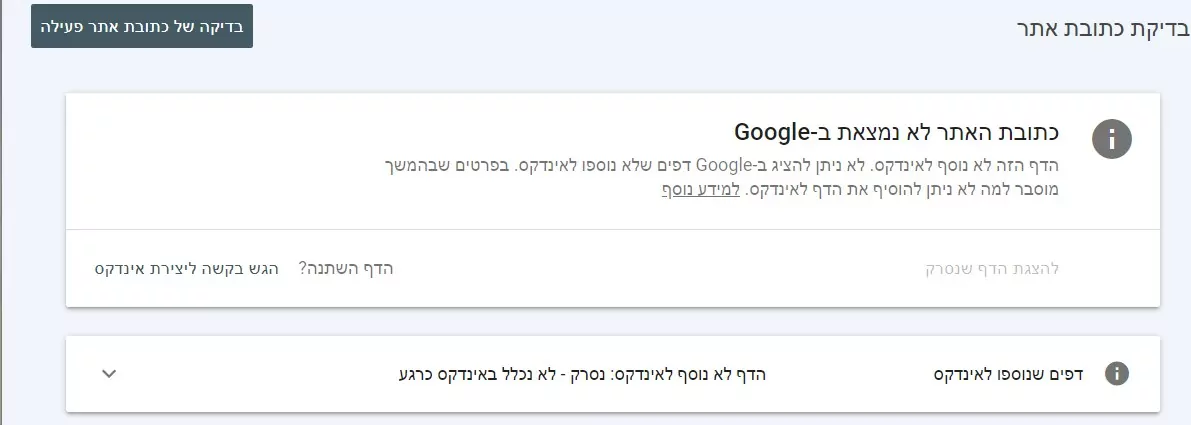

אם הדף לא נסרק – תקבלו אפור כזה, כמו שמדמיינים בבדיחות על פולניה ממורמרת.

ולמטה גוגל תכתוב לכם מה הסיבה שהדף לא נסרק.

איך נבדוק את הסריקה בכל דפי האתר

אפשר לבדוק את כל הדפים בלחיצה על "דפים" בסרץ' קונסול ושם לראות את כל הדפים שנוספו / לא נוספו לאינדקס ומה השגיאות הקיימות – וכמובן לבצע את התיקונים הנדרשים כדי לבקש להוסיף את העמוד בחזרה לסריקה ושגוגל תאנדקס אותו.

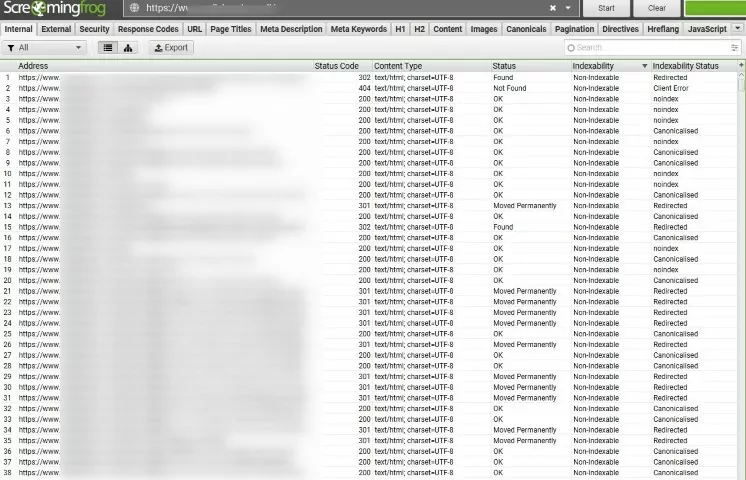

דרך נוספת שאני אוהבת, היא לבדוק את הסריקה בכל דפי האתר באמצעות Screaming Frog . הכלי האדיר הזה יראה לי , בין היתר, איפה הבעיות שיש בסריקה ברמה מאוד מפורטת.

עם זאת, לצערי, הצפרדע היא עדיין כלי שמדמה את הזחלנים ולא הדבר עצמו ולעתים אני צריכה לבדוק ידנית בעיות פרטניות אבל במרבית המקרים זה נותן את התמונה האמיתית והמלאה, ובאמצעותו אפשר לאבחן ומצוא את כל הבעיות הטכניות שקשורות לסריקת האתר.

אז מה התכלס? מה לעשות עכשיו כדי למצוא ולפתור שגיאות בסריקת האתר.

באמצעות המידע והכלים שסקרנו למעלה, הנה צ'ק ליסט לבדיקת שגיאות ולשיפור יכולת הסריקה של האתר שלך:

1. בדיקת תקינות קובץ robots.txt

כפי שציינתי מעלה

2. היררכיית ומבנה האתר אתר

השתמש בכלי הדמיה כמו Screaming Frog כדי לראות את מבנה האתר שלך.

הדמיות ויזאוליות נותנות פרספקטיבה של נתונים בסיסיים שלעתים קשה יותר לחשוף בנתונים מספריים.

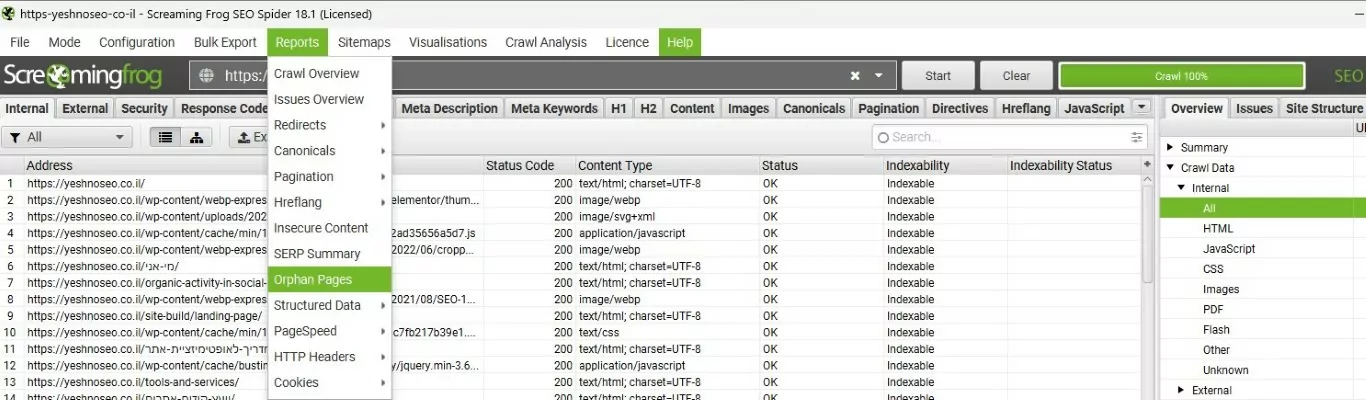

3. עמודים יתומים

מצאו את העמודים שאין אליהם קישורים פנימיים מעמודים אחרים באתר.

איך נעשה את זה? כמובן באמצעות סקרימינג פרוג:

i. סרקו את האתר באמצעות בחירה ב Crawl Linked XML Sitemaps Configuration > Spider > Crawl’

ii. חברו את גוגל אנליטיקס לכלי – Configuration > API Access’

iii. בחרו ב rawl New URLs Discovered In Google Analytics’

iv. חברו את גוגל סרץ' קונסול Configuration > API Access

v. בחרו ב ‘Crawl New URLs Discovered In Google Search Console’

vi. סרקו את האתר

vii. לחצו על Crawl Analysis > Start’ to populate orphan URLs filters

viii. פלטרו ל ‘Orphan URLs’ בטאבים של sitemaps, analytics and Search Console

ix. כעת תייצאו את הדוח ‘Reports > Orphan Pages’

4. קישורים פנימיים

בדקו שאין בעיות של קישורים פנימיים ובצעו תיקוני שגיאות ואופטימיזציה איפה שצריך:

לדוגמה:

• וודאו שכל הקישורים הפנימיים הם "do follow"

• תקנו או הסירו קישורים שבורים

5. סטטוס קוד

בדקו שכל העמודים מקבלים סטטוס קוד 200 – כך הוא שתקין וקריא.

אבל אם ישנה בעיה של סטטוס לא תקין כמו ברשימה הבאה, טפלו:

- 0 – Blocked By Robots.txt

- 0 – DNS Lookup Failed

- 0 – Connection Timeout

- 0 – Connection Refused

- 0 – Connection Error / 0 – No Response

- 301 – Moved Permanently / 302 – Moved Temporarily

- 400 – Bad Request / 403 – Forbidden / 406 – Status Not Acceptable

- 404 – Page Not Found / 410 – Removed

- 429 – Too Many Requests

- 500 – Internal Server Error / 502 – Bad Gateway / 503 – Service Unavailable

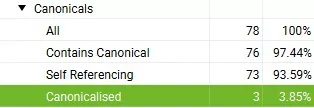

6. תג Noindex ושגיאות של תג קנוניקל

תג noindex אומר לגוגל אל תסרוק את העמוד הזה .

meta name="robots" content="noindex"/>

ותגיות קנוניות אומרת לגוגל שזהו לא העמוד המקורי ומפנה אל עמוד התוכן המקורי . לפעמים זה סתם עניין של הפניות לא נכונות לכותבת url עם / או בלי / וזה לא תקין אז כדאי לפתור את הבעיה.

rel="canonical"

עם סקרימיניג פרוג תוכלו למצוא את התגים הללו בקלות.

7. בדיקת דפים וסריקות עם גוגל סרץ' קונסול. שם תקבלו את כל המידע העדכני ביותר מגוגל עצמו.

אם עדיין אין לכם מעקב של גוגל סרץ קונסול באתר- מומלץ להתחיל זאת עוד היום כי לוקח קצת זמן עד שצוברים מספיק נתונים כדי להתחיל לעבוד ולתקן את השגיאות (במידה וקיימות)

לסיכום – איך נשפר את סריקת האתר ב 10 נקודות

- בדיקת תקינות קובץ robots.txt

- בדיקת תקינות מפת אתר sitemap xml

- אופטימיזציה למבנה והיררכיית האתר (קישורים פנימיים)

- תיקון קישורים שבורים

- תיקון עמודים ייתומים

- תיקון עמודים שמקבלים שגיאה בסטטוס קוד שלהם

- תיקון של לופים של הפניות (301 ל301 ל 301…)

- הסרה של תגית noindex מעמודים שצריכים להיות מאונדקסים.

- תיקון של שגיאות קנוניקל

- וודאו שאין לכם בעיות עם מה שנקרה "תקציב הזחילה" (כנראה שאין לכם)